AI 工具的進步和普及,使得深度偽造技術變得更加容易使用和濫用,近期美國當紅歌手Taylor Swift 就深受其害,以她目標偽造的性暗示偽造圖片在 X(前身為 Twitter)上廣為流傳;促使她的數百萬粉絲聚集在一起,以「保護 Taylor Swift」的網路運動要求帖子將這些 AI 圖片下架。這個舉動雖然成功了,並能夠在一定程度上減輕影響,但無法阻止這則新聞登上每個主要媒體,引發全面的討論。

在接下來的幾天裡,對於深度偽造的傷害展開了全面的討論,不僅局限於Taylor Swift的事件,還包括過去幾年中出現的其他名人和網紅被深度偽造攻擊的案例。事實上,這樣的事件只會隨著時間推移而增加,因為隨著 AI 工具的不斷進步和普及,深度偽造技術將變得更加普及和易於使用。

Attestiv 公司 CEO Nicos Vekiarides 指出,人們可以用自己的短片創建一段新的人物對話影片--如果你想如果你想製造虛擬的自己,這會很有趣,但壞處是其他人也可以輕鬆創建一段讓你傳播假信息的影片,並可能損害你的聲譽,更糟的是你並不知情。

隨著能夠製作深度偽造內容的 AI 工具不斷增加和進步,網路世界將充斥著誤導性的圖像和視頻。這就引出了一個問題:人們該如何辨別真偽?

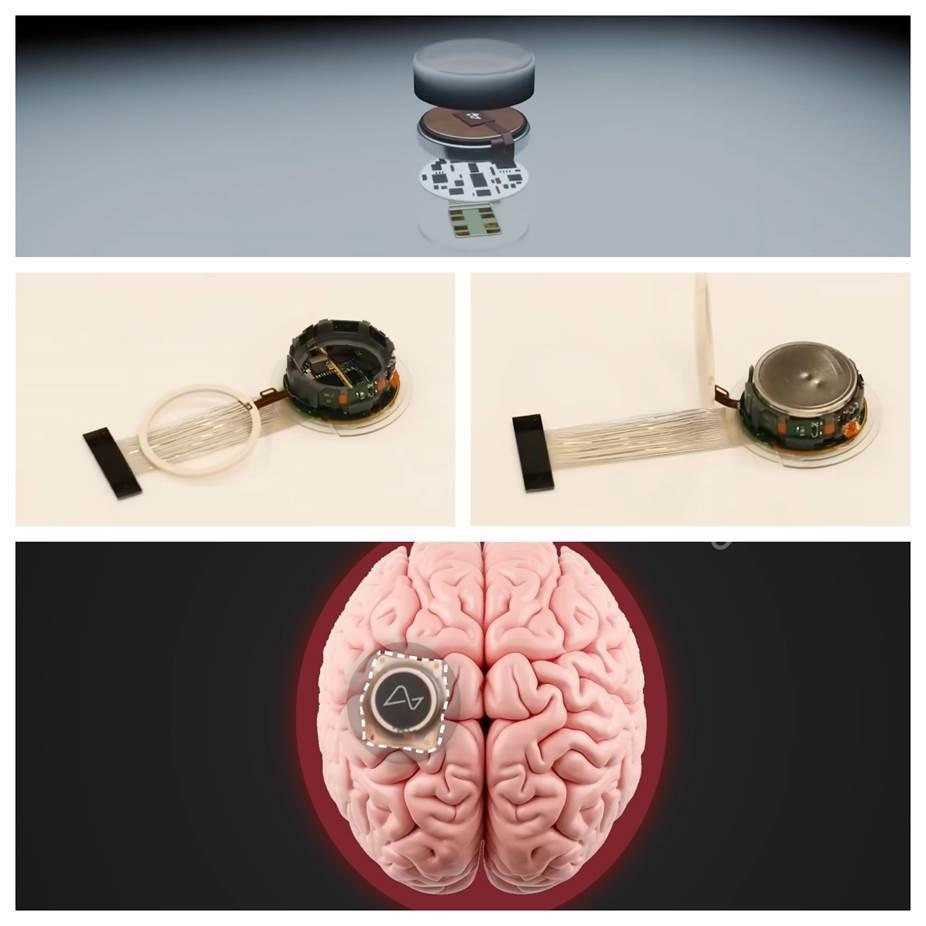

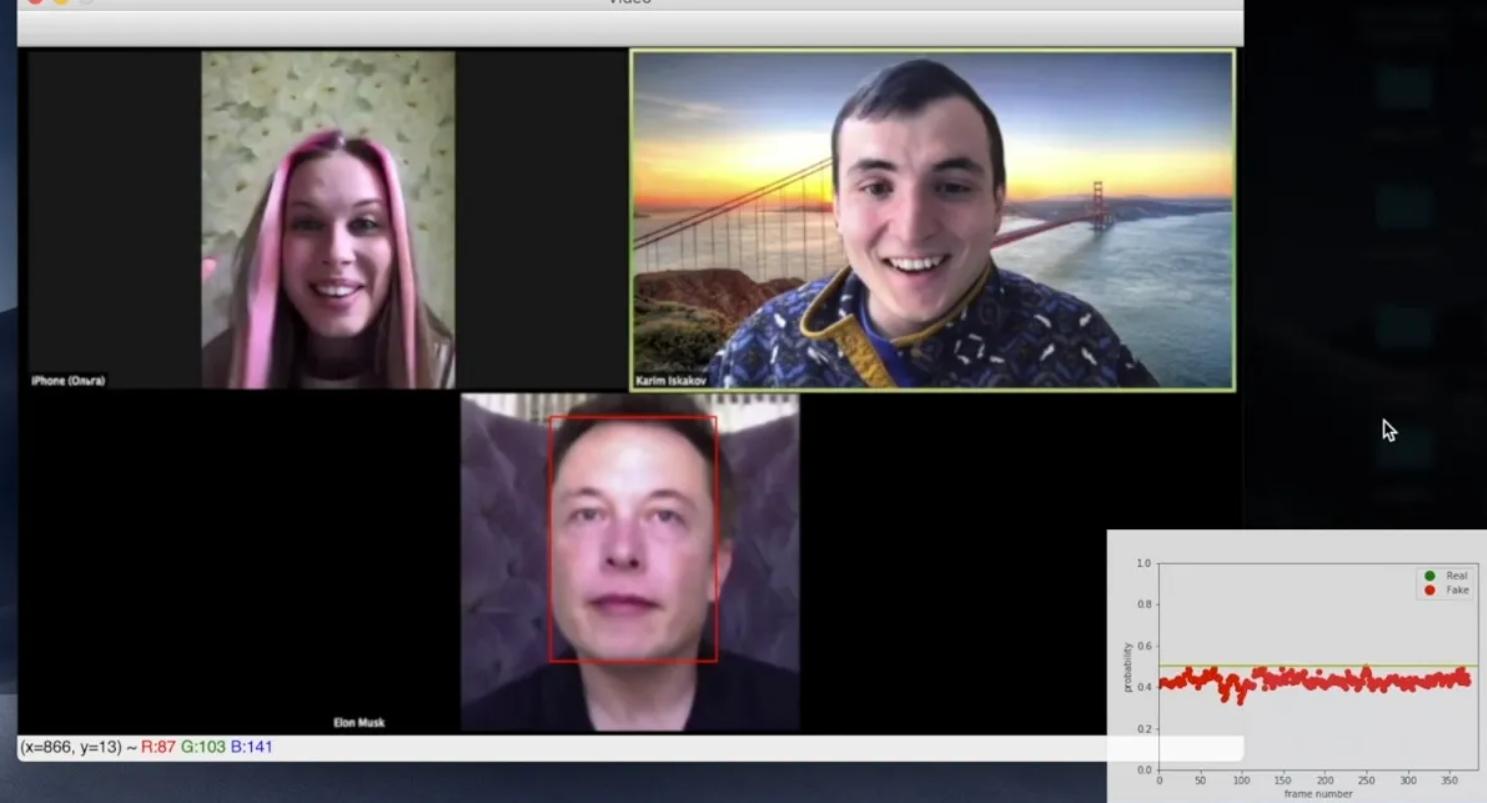

深度偽造技術的崛起帶來了廣泛的危害,目前的AI已經可以使用自我學習的演算法建立任何個人的人造圖像、影片或音訊。最初,深度偽造主要圍繞著臉部交換,其中一個人的相似之處被置於現有的影片和圖像上。過去這需要大量的處理能力和專業知識,然而隨著時間的推移,利用文字生成 AI 技術的崛起使得每個人都能夠創建幾乎真實的操縱內容,從而進一步擴大了深度偽造的範圍和影響力。

這種易於取得的方式可能帶來深遠的後果,從損害公眾人物的聲譽和在選舉前誤導選民,到欺騙毫無戒心的人進行難以想像的金融詐騙或繞過組織設置的驗證系統…等。網絡安全公司 McAfee 的 CTO Steve Grobman 指出,該公司一直在調查這一趨勢並發現了「快取造假」的增加,這是一種騙局者拿取一些真實的影音素材,通常來自可靠來源或名人的部分真實訪談,但是將其剪輯並與錯誤的上下文結合起來,成為推動假訊息的散播工具。」

為了應對這個問題,需要緊密合作的跨學科團隊,包括 AI 專家、法律專家、政府機構。這些努力需要針對性地提高公眾對於深度偽造的認識,同時加強技術解決方案和法律法規的發展,以防止深度偽造技術被濫用。

深度偽造技術的不斷進步讓檢測這類內容變得更加困難,以下是專家們提供了一些方法來識別可能是由 AI 生成的內容:

首先,觀察內容中的微小異常是一個重要的方法。在圖像和影片中可能會存在一些不自然的特徵,例如手部或嘴唇動作不自然、背景不真實、運動不均勻、光線變化等。其次,畫面的真實性也是關鍵,對於圖片可以查找缺少陰影和物體之間不一致的跡象,或觀察人類特徵的渲染是否不佳,例如手/手指和牙齒等;如果圖像過於完美或對稱度過高,則可能是由 AI 生成的。

在觀看影片時,考慮內容的來源、可能的偏見以及創建內容的動機也非常重要。應該對來源不明確的影片持懷疑態度,並注意是否有任何鼓勵使用非傳統付款的方式來交易,這可能表明該影片是一種詐騙。技術商也現今在努力開發更精密的檢測技術來幫助辨別真偽,一些公司已經開始利用 AI 技術來檢測內容的真實性。例如,Google和ElevenLabs 正在探索這一領域,而 McAfee 則推出了一個專案來辨認 AI 生成的音訊。

總體而言,檢測出假影片需要結合人工智能和人類判斷力,通過識別微小異常、再次確認來源的真實性以及使用先進的檢測技術,我們可以更有效地辨別真假內容,而不要隨意散布的關鍵責任則在我們自己身上。

相關文章